2025年7月23日に「【生成AI活用×データ解析】プロが徹底議論!AIエージェント時代マーケの解析・示唆だしはどこまで自動化するのか?」というテーマでウェビナーを開催しました。ご参加いただいた皆様、誠にありがとうございました!

本ウェビナーでは、生成AIからWebサイト改善の有効なヒントを獲得する具体的な手法と、第一線で活躍するプロたちの、AIに対するリアルな視点や思考法を解説しました。

この記事では、本ウェビナーの内容をまとめていきます。

1. AIエージェントによるWebログ分析自動化は実現できるのか?

Web解析の専門家たちの間では、「AIによるWebログ分析はまだ実用段階に達していない」という見方が一般的です。多くの人が「数年後にはできるようになるだろう」と予測しています。しかし本記事では、AIはすでに実用レベルで分析をこなせると考え、その実現可能性について検証しました。

まず、この検証にあたり「分析」の定義を明確にしました。

単にデータを集計するだけでは「分析」とは言えません。そのため、「分析」とは「サイトオーナーが気づいていなかった、アクションに繋がるレベルのアドバイスを、データに基づいた一定の合理性を持って提案してくれること」と定義しました。

本記事では、この「分析」の定義に基づき、「AIエージェントによるWebログ分析の自動化が実現できるのか?」を、実際の検証を通して説明します。

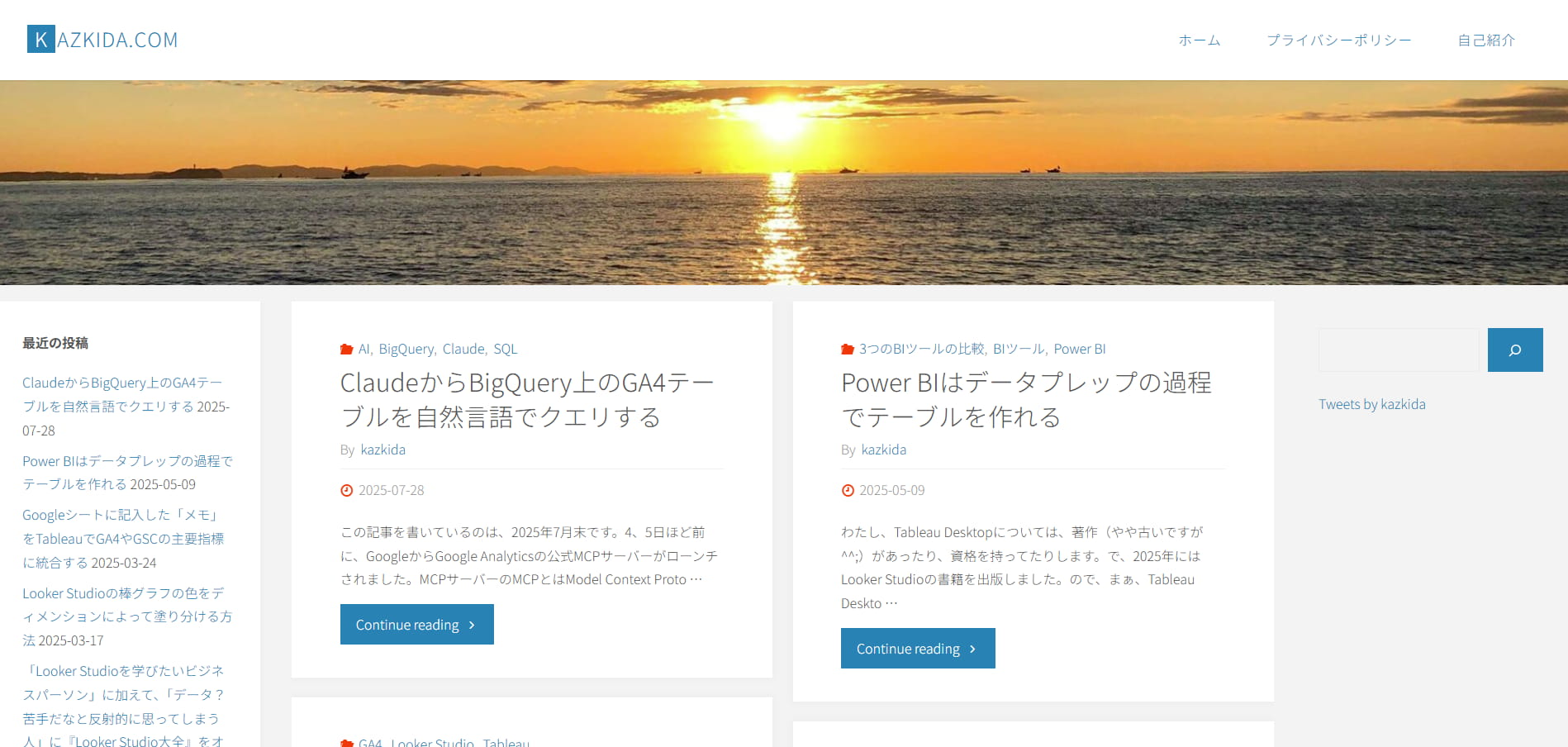

分析対象サイト

今回の検証では、個人ブログサイト「kazkida.com」を対象に、AIエージェントを使って分析しました。

このサイトは、技術記事の公開と、記事内から書籍購入(amazon)やオンライン講座(Udemy)への誘導を目的としています。そのため、このサイトのKGIは「記事から書籍購入やオンライン講座への誘導」です。

このKGI達成に対し、AIが「サイトオーナーが気づいていなかった、アクションに繋がるレベルのアドバイスを、データに基づいた一定の合理性を持って提案してくれるのか」を検証していきます。

2. データの準備と加工

AIに高度な分析をさせるためには、ただ漠然とデータを渡すだけでは不十分です。そのため、AIが理解し、活用できる形にデータを整える「データプレパレーション(データの事前準備)」が、最も重要なステップです。

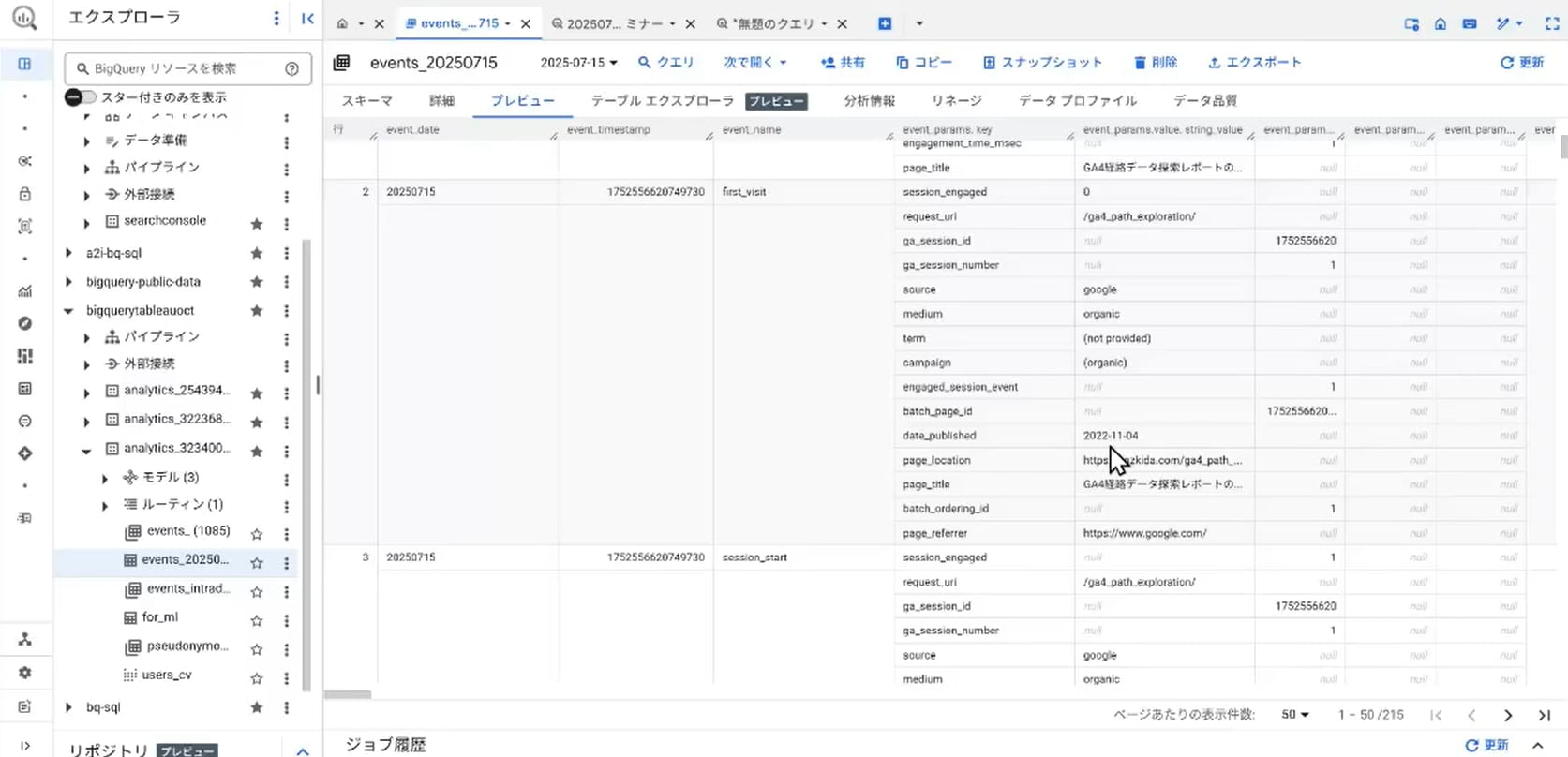

元データの準備:GA4とBigQueryの連携

まず、分析の元となる対象サイトのデータをGA4(Google Analytics 4)とBigQueryを連携させて取得しました。

取得したデータは、日付、時間、イベント名、ページURL、参照元など、非常に膨大です。しかし、これらのデータは、GA4とBigQueryを連携させれば誰でも取得できます。

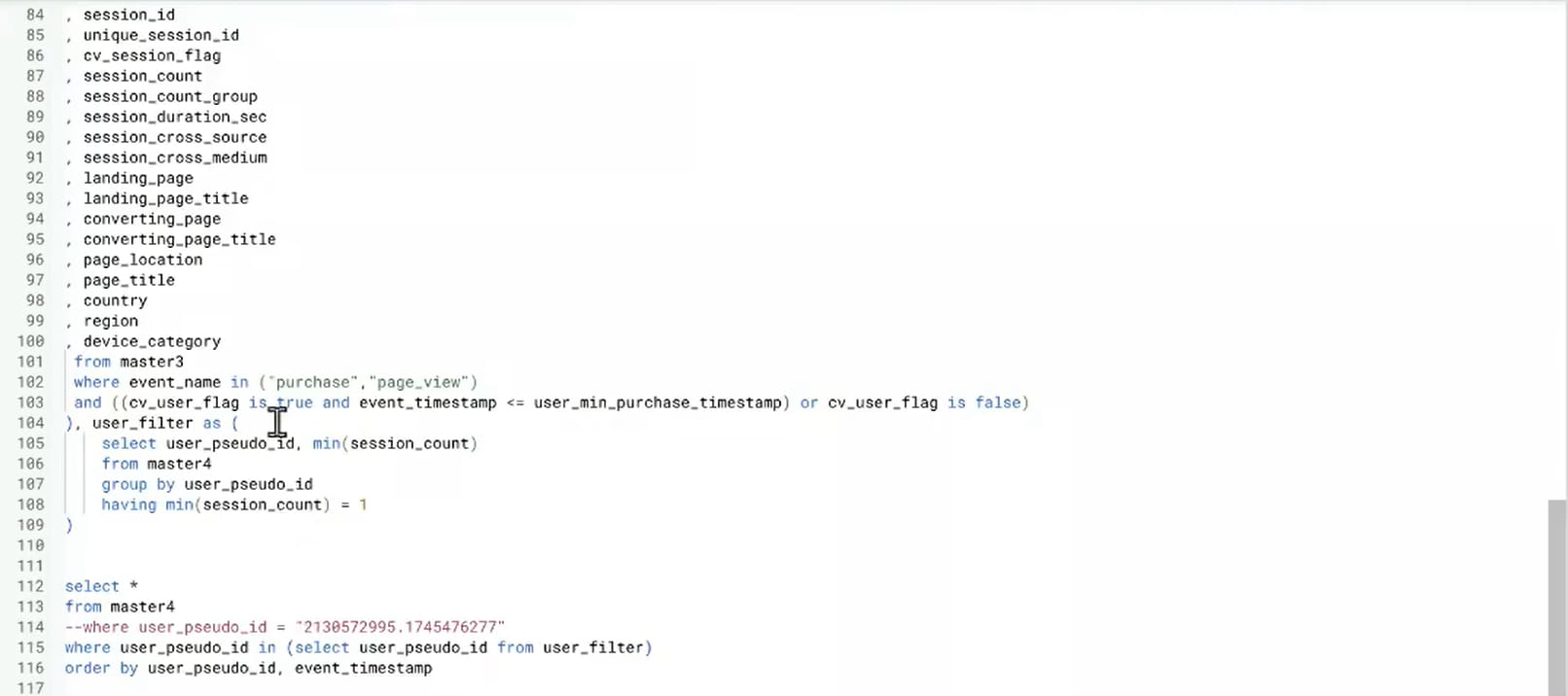

データプレパレーション:SQLによる加工

次に、この元データをAIが分析しやすいように加工します。今回は、約100行のSQLで加工処理を行いました。

具体的には、以下のような工夫を施しました。

- スパムボットのアクセスや「ページが見つかりません」といった無意味なデータを削除。

- 訪問回数に応じて、「初回訪問」「常連訪問」といったセグメントを追加。

- 訪問日を「曜日」、時間を「時間帯」に変換。

この作業は、単にデータを整備するだけでなく、「どうすれば分析に役立つか」という人間の知恵をデータに注入するプロセスです。人間側が仮説を立て、それをAIが検証できるような形にデータを整えます。

SQLでデータを整形した後、その結果をCSVファイルにエクスポートします。これは、現状のAIエージェントでは、BigQueryとシームレスに連携してデータ処理する機能はまだ一般的でないためです。CSVファイルに一度データを吐き出すことで、AIが読み取り可能な形式に変換します。

ここまでが、「データプレパレーション」の工程となります。

3. AIエージェントの選定とプロンプトの設計

次に、分析の核となる「AIエージェントとプロンプト」について詳しく解説します。

表形式データに特化したAIエージェントの選定

AIにログデータを分析させるにあたり、ChatGPT・Claude・Geminiなど複数のAIエージェントを試しました。その結果、Genspark スーパーエージェントの「AIシート」が、今回のタスクに最も適していると判断しました。

理由としては、多くの生成AIは文章の要約や生成が得意な一方で、大量の表形式データを扱うのが苦手です。しかし、GensparkのAIシートは、この表形式データの扱いに長けており、表形式データを高度に分析できるからです。

分析を成功に導くプロンプトの設計

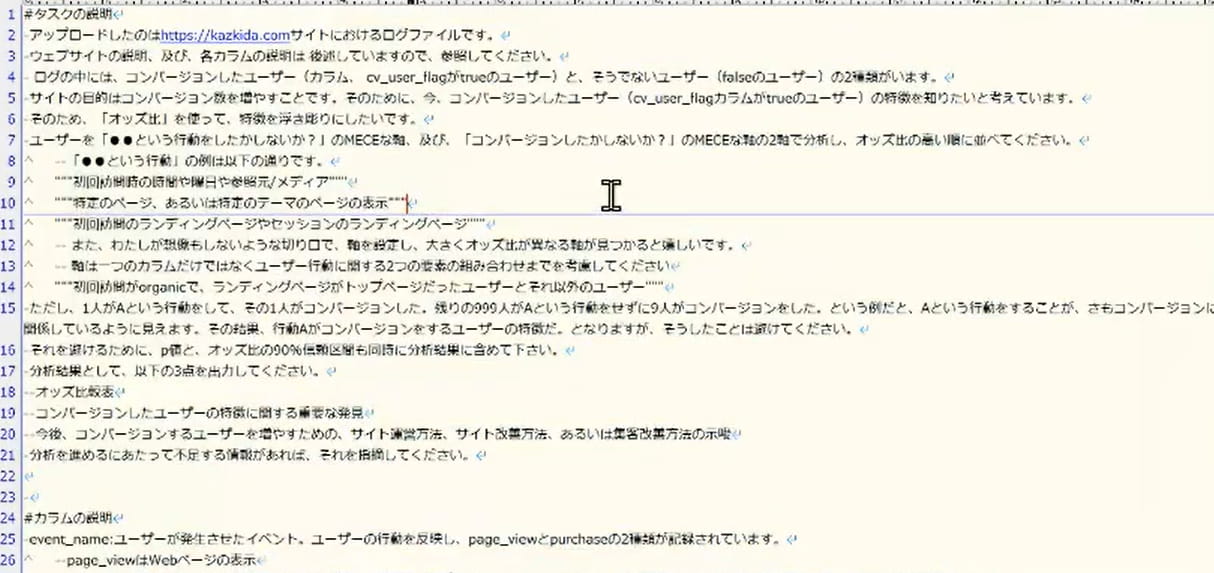

次に、AIエージェントに適切な指示を与えるプロンプトです。今回のプロンプトは、約70行に及びます。

プロンプトは、「タスクの指示」「カラム(列)の説明」「ウェブサイトの説明」の3つの要素で構成しました。

タスクの指示

「アップロードしたデータを使って、コンバージョンしたユーザーの特徴を分析してください」と明確に依頼しました。その際、「オッズ比」を使って分析するように指定しました。

※オッズ比:ある要因が結果に影響する度合いを表す統計指標です。医療分野でよく用いられ「煙草を吸う」という要因が「肺がんになる」という結果にどの程度影響するかを示す際に利用されることがあります。プロンプトでは、「特定の行動をする」という要因が「コンバージョンを起こす」という結果に影響する度合いを示すよう指示をしています。

カラム(列)の説明

分析データの各列が何を意味するかを、誰でも理解できるように詳細に説明しました。

→例:「landing_page」は「セッションの最初にユーザーが表示したページ」である

ウェブサイトの説明

サイトのトップページ、自己紹介ページ、ブログ記事の役割などを細かく説明しました。

これらのプロンプトにより、AIは単なるデータだけでなく、サイトの構造や文脈を理解し、より意味のあるアドバイスを生成できるようになります。この「詳細なプロンプト」が、AIによる精度の高い分析を可能にします。

4. AIが導き出した分析結果

データプレパレーションとプロンプトの準備が完了後は、AIエージェントに分析を依頼しました。

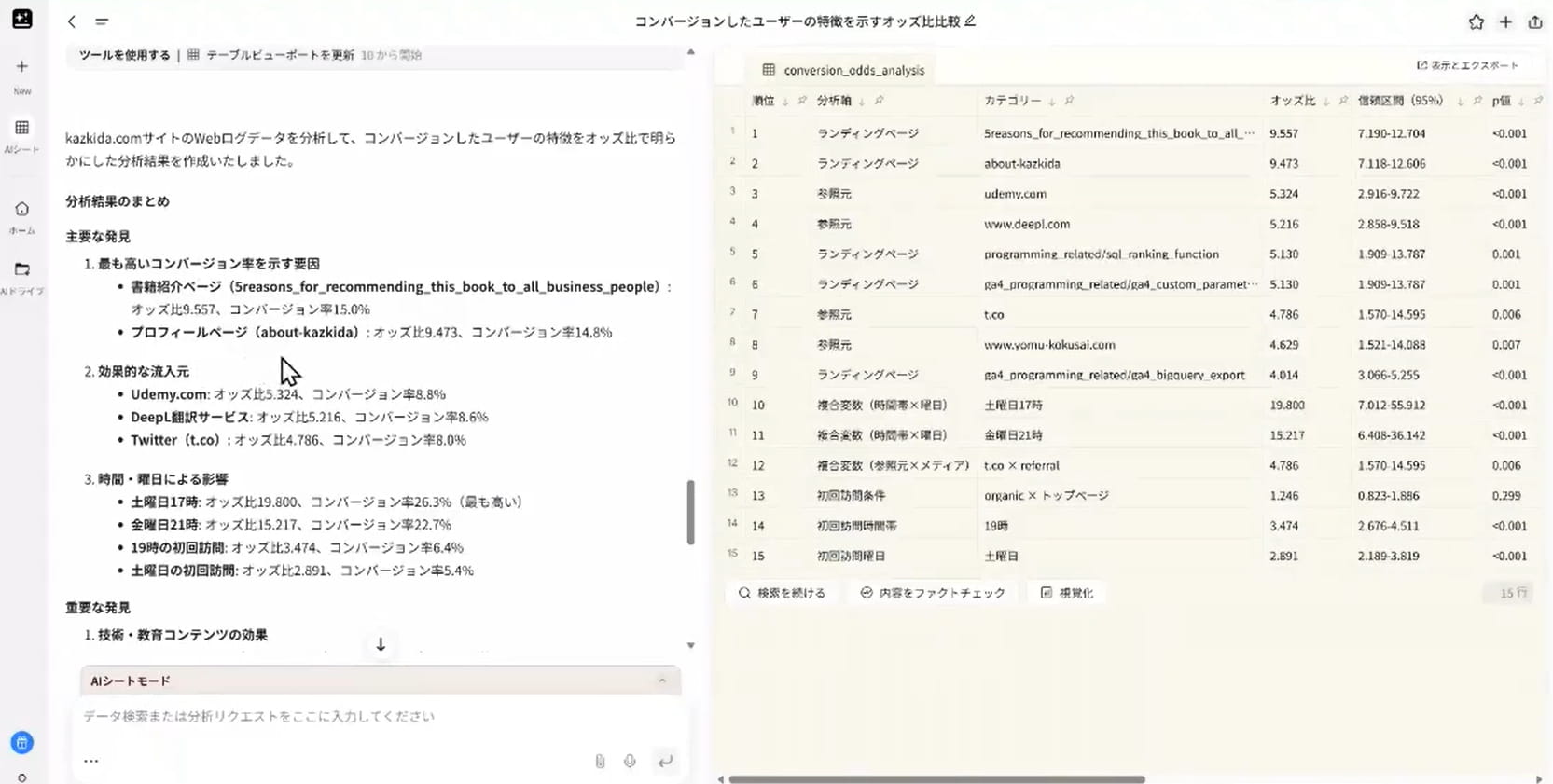

分析の結果、AIは以下のインサイトを提案しました。

データに基づいた具体的な示唆

- 書籍紹介ページの効果:

「この本をおすすめする5つの理由」といった書籍紹介ページが、他のページに比べて9.5倍も高いオッズ比でコンバージョンに貢献している。 - プロフィールページの効果:

プロフィールページを訪れたユーザーも、コンバージョンに繋がりやすい。 - 訪問時間帯の傾向:

ビジネスユーザーが活発な平日ではなく、土曜日の夕方(17時)に訪問したユーザーのコンバージョン率が高い。

これらの分析結果は、単なる表面的な数字ではありません。オッズ比や信頼区間、p値といった統計的な指標が提示されているため、この提案には確かな根拠があります。

人間では気づかなかったインサイト

今回、サイトオーナーの木田は、「ビジネスユーザーが仕事の合間に学びたいと思って、平日に訪問するだろう」という仮説を立てていました。しかし、AIの分析結果で「土曜日の夕方」がユーザ-のコンバージョン率が高いということが分かりました。

5. 結論

今回の検証で、AIは、人間の固定観念を覆す新たな行動戦略(週末の夕方をターゲットにしたコンテンツ配信など)を提案しました。

「サイトオーナーが気づいていなかった、アクションに繋がるアドバイスを、データに基づいた説得力を持って提案してくれる」

AIは、この「分析」の定義を満たしました。

当然、どのサイトでも同じように成功するわけではありません。しかし、少なくとも今回のケースでは、AIが実用的な分析を成し遂げたという事実が確認されました。

AIを分析に使うにあたって重要なのは、AIを単なるツールとして使うのではなく、「適切なデータ」と「明確な指示(プロンプト)」を準備することです。これにより、AIは単なる計算機を超え、あなたのビジネスを加速させる強力なパートナーとなります。

Webマーケティングの世界は、AIの進化とともに劇的に変化しています。今回の事例が、皆さんのビジネスにおけるAI活用のヒントになれば幸いです。

6. まとめ

本ウェビナーでは、AIエージェントを活用したWebログの分析自動化について、その具体的なプロセスと可能性を解説しました。

こんな方におすすめ

- AIを活用したデータ分析を始めたい方

- データプレパレーションやプロンプトの設計のノウハウを知りたい方

- GA4やBigQueryのデータの活用を知りたい方

また、弊社ではデータ基盤の整備から、GA4やBigQueryに関するご支援を多数行っております。お困りごとがある際は、いつでもお気軽にお問い合わせください。