Search ConsoleデータをBigQueryへ一括エクスポートさせる機能がリリースされてから、早1年が経過しました。まだご存知ではない方は、以下のリリース記事を参照ください。

一括データ エクスポート: Search Console のデータを活用するための優れた新機能 | Google 検索セントラル ブログ | Google for Developers

この機能リリースは、検索領域を専門に扱うマーケターにとって、より分析の幅を広げることのできる機会ではないかと考えています。本記事では、Search Consoleを活用した分析手段やBigQueryへどのようなデータが格納されているのか、そして今後の展望などを解説します。

BigQueryへの連携方法については、弊社副社長木田のブログで詳しく解説しておりますので、こちらも参照ください。

BigQuery上のGSCデータをLooker Studioで可視化してみた – kazkida.com

Search Consoleを活用した分析手段について

Search Consoleには大きく分けて、3つの分析手段があると考えます。

- ブラウザーなどでSearch Consoleを開き、流入クエリなどを分析する

- Search Console APIを使用し、BIツール(Looker StudioやTableauなど)で可視化し、分析する

- BigQuery一括エクスポート機能を活用し、BIツール(Looker StudioやTableauなど)で可視化し、分析する

それぞれの手段におけるGOODとBADを整理してみました。

| Search Console | Search Console API | Search Console x BigQuery | |

|---|---|---|---|

| GOOD | ・検索パフォーマンスや流入クエリがそれなりに把握・分析できる ・いつでもサクッと分析できる |

・検索タイプや期間、ディメンションなど自由にデータを抽出できる ・フィールド計算を使用すれば、正規表現などカスタマイズできる ・さまざまなデータソースと連携ができる |

・1日あたりのデータ行数制限が存在しない ・直接エクスポートやAPIとは異なり、匿名化クエリもエクスポート対象 |

| BAD |

・上限1,000行までしかエクスポートできない ・最大16ヶ月までしか遡れない ・クロール統計情報が簡素 ・3条件以上の複雑な絞り込みができない ・日別データの抽出ができない |

・50,000行/1日の抽出上限があり ・使用回数制限がある ・SQLが使えない |

・BigQueryへ接続した日からデータが蓄積され始める |

標準のSearch ConsoleやAPI経由では、抽出条件や回数に制限があるため、中規模〜大規模サイトでは分析するデータ量としては物足りない可能性があります。

BigQueryへエクスポートすると、データ蓄積は接続した日から始まるものの、行数制限がなくデータを分析できる点が強力な武器であると考えます。

どのようなデータが格納されているのか

この章では、下記2パターンについて、どのようなデータが格納されているのかを整理・解説します。

- Search Consoleコネクターを使用し、Looker Studio経由で可視化した場合

- BigQueryへ一括エクスポートし、Looker Studio経由で可視化した場合

Search Consoleコネクターを使用し、Looker Studio経由で可視化した場合

まず、前提としてLooker StudioにはSearch Consoleのコネクターが用意されていますが、データ取得にはAPIが使用されています。Search Console APIに備わっている”Search Analytics”という機能を介して接続され、検索パフォーマンスに関するデータが取得・表示されます。

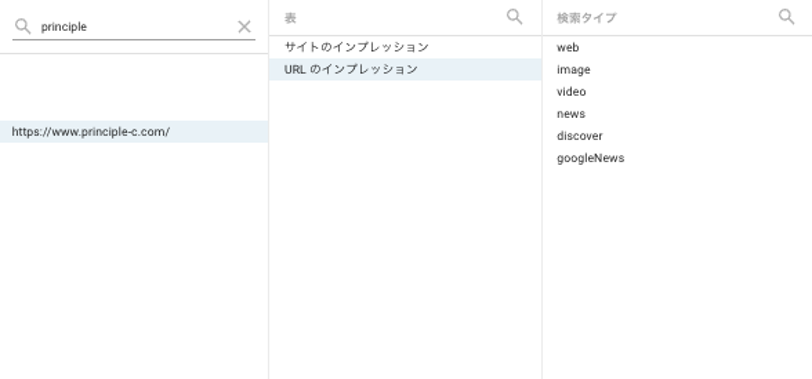

加えて、Search Consoleには2つの集計データソースが存在します。ここでは、Googleヘルプをそのまま引用します。

プロパティごとの集計 (サイトのインプレッション)

同じSearch Consoleプロパティを指す同じクエリに対するすべての結果が、合計で1回カウントされることを意味する。そのため、クエリに同じサイトのURLが2つ含まれている場合(example.com/petstore/giraffeとexample.com/recipes/pumpkin_pie)、結果がプロパティごとに集計されると1回のインプレッションとしてカウントされる。

ページごとの集計 (URLのインプレッション)

同じページを指していても、検索結果の各URLが1回ずつカウントされる。

この集計方法では、クエリに同じサイトのURLが2つ含まれている場合(example.com/petstore/giraffeとexample.com/recipes/pumpkin_pie)、2 回のインプレッションとしてカウントされる

実際にLooker StudioからSearch Consoleコネクターを接続し、プロパティを選択すると、どちらかの表形式(サイト or URL)を指定するように要求されます。

サイトのインプレッションでは、プロパティごとにカウントされてしまう為、分析の際には「URLのインプレッション」を選択する方が好ましいです。

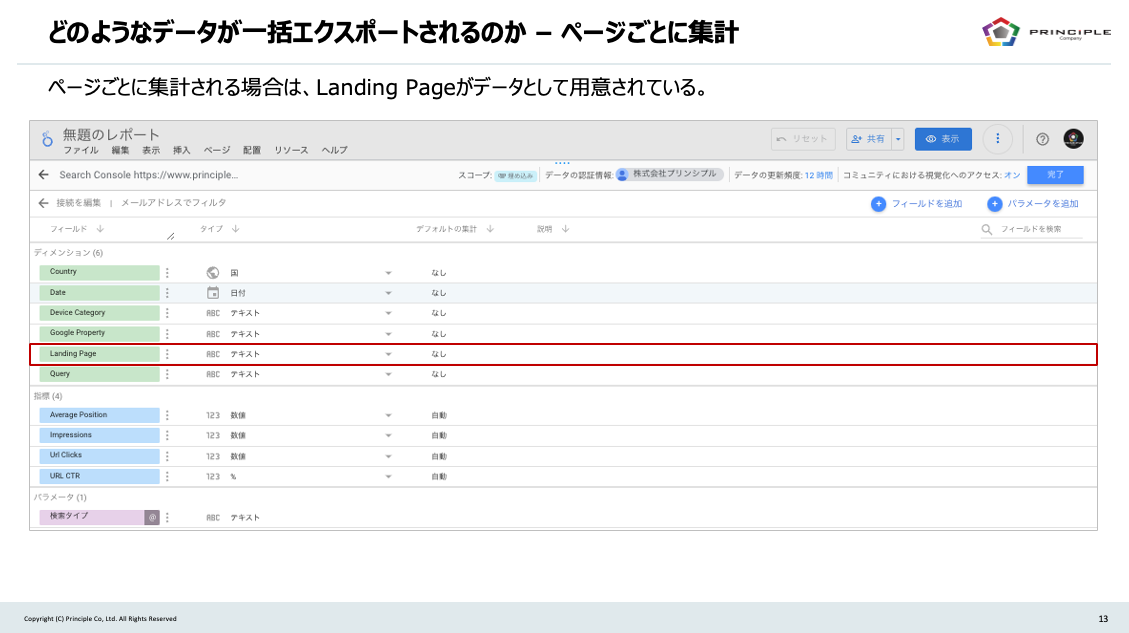

普段、Search Consoleで見るようなディメンションや指標が格納されています。また、URLのインプレッションはランディングページごとに集計される為、Landing Pageという項目も用意されています。

ディメンション:

Country

Date

Device Category

Google Property

Query

指標:

Average Position

Clicks

Impression

Site CTR

パラメーター:

検索タイプ

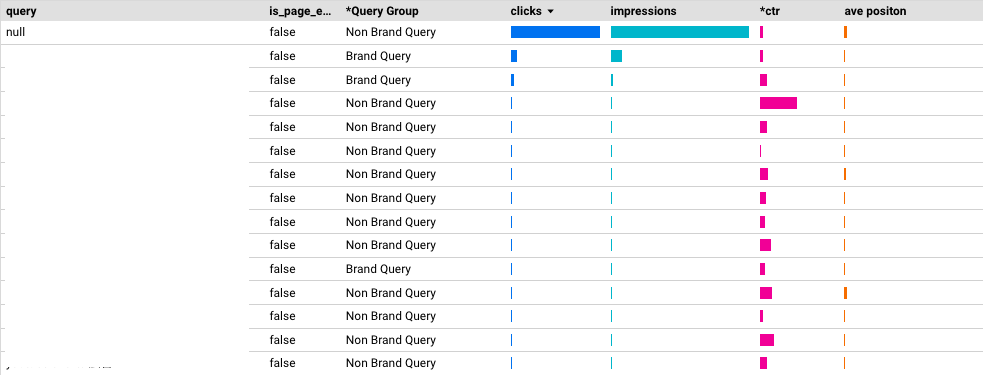

BigQueryへ一括エクスポートし、Looker Studio経由で可視化した場合

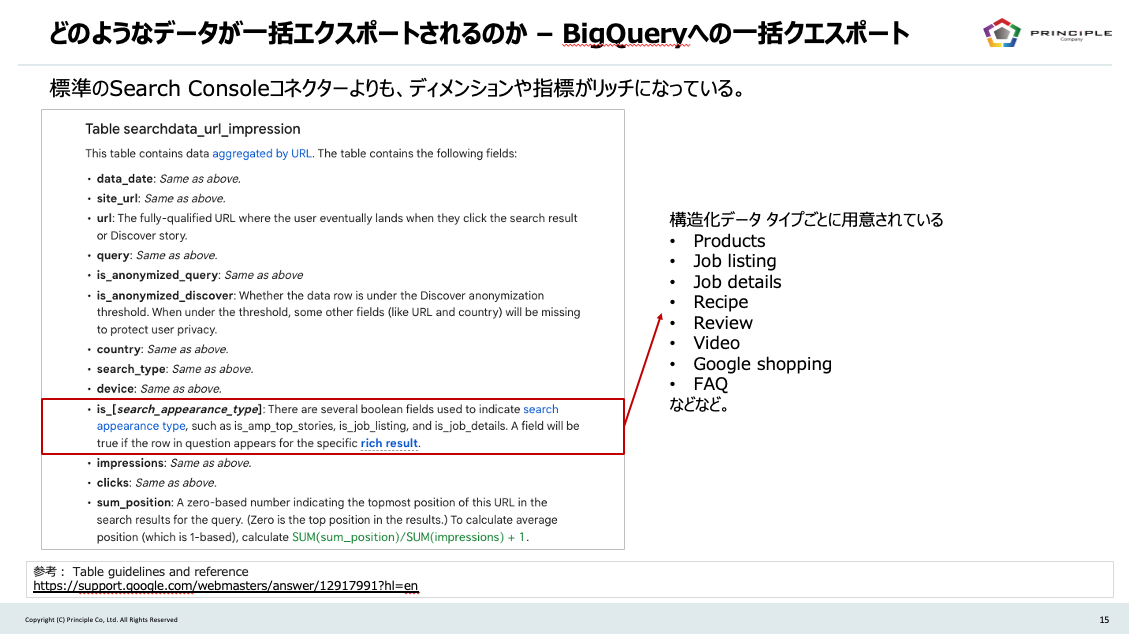

次に、BigQueryへ一括エクスポートした場合に、どのようなデータが格納されているのでしょうか。結論からいうと、標準のSearch Consoleコネクターよりもディメンションや指標がリッチになっています。

BigQueryへエクスポートすると、3種類のデータソースが用意されます。

- searchdata_site_impression

- searchdata_url_impression

- ExportLog

※ ExportLogには、どのようなデータが保存されたのかログが記録されてます

今回は、searchdata_url_impressionの表形式データを使用します。ディメンションや指標については、すべてを書き出すと長文になってしまうので、スライドで共有します。

より詳細について知りたい方は、以下のリンクから参照ください。先ほどのSearch Console APIより、リッチな項目が得られることがわかります。

Table guidelines and reference – Search Console Help

BigQuery一括エクスポートでは、より生データを扱うことができる

Looker StudioやTableauで分析をする場合、主には標準コネクター(Search Console API)とBigQueryエクスポートが挙げられますが、BigQueryであればより生データを扱うことができます。

少し話が脱線しましたが、まず「is_anonymized_query」について補足します。

Search Consoleのクエリデータには、匿名化クエリ(anonymized query)と呼ばれるデータが存在します。主に個人情報や機密情報を含むクエリを指し、全体の50%以上が匿名化されたクエリであるという調査結果が出ています。

実際に弊社サイトでも、約67.2%が匿名化クエリであり、実際の流入クエリはnull扱いとなっています。

上記の点を踏まえ、実際に標準コネクター(API)とBigQueryエクスポートを比べてみました(データ元は弊社コーポレートサイトを使用)。

※ 数値の乖離度合いを図る為に、データが多い側を基準として、縦棒を置いています。

両者を比較すると、ページごとに集計(標準コネクター)よりもsearchdata_url_impression(BigQueryエクスポート)の方が表示回数・クリック数ともに多くのデータが取得できていることが分かります。(今回はコーポレートサイトを対象にした事情もあり、サイト規模によっては乖離はさらに広がる場合があると思われます。)

データ抽出の上限がなく、匿名クエリもデータの一部として獲得できることから、BigQuery一括エクスポートはより生データに近い分析が可能となります。

まとめ

Search ConsoleのBigQuery一括エクスポートが実現されてから、約1年が経過しました。サイト規模によっては、普段のSearch Console画面で分析自体は事足りるかもしれません。しかしながら、とくに中〜大規模サイトを運営されている事業者様には、ぜひこの記事を機にBigQueryへの一括エクスポートを検討されることをオススメしたいです。

データ抽出上限がないことで、より生データに近い分析が可能になるだけではなく、GA4・広告・CRMデータといった多様なデータソースとの連携など、今後分析の幅が広がると思われます。

昨今では、「データドリブン」という言葉がさまざまなフィールドで活用されていますが、本記事のテーマもその1つに結びつくのではないでしょうか。